Computermodellen geven inzicht in verborgen factoren overleving borstkanker

Interpretatie van prognosemodellen is lastig en complex. Tom Jansen (Vrije Universiteit) en collega’s hebben twee methoden (LIME en SHAP) gebruikt om de prognose van computergestuurde modellen te interpreteren. Het is de eerste stap om beter inzicht te krijgen in achterliggende factoren die de overleving beïnvloeden; iets wat de prognosemodellen op basis van kunstmatige intelligentie voor borstkanker zelf niet prijs geven.

Computergestuurd leren en kunstmatige intelligentie kunnen bijdragen aan het verbeteren van diagnostiek, besluitvorming rond oncologische behandelingen en het beter begrijpen van de ziekte kanker. Echter, de geringe verklaarbaarheid hoe de "black box" bij computergestuurd leren zijn resultaten genereert verhindert adaptatie van deze techniek in de klinische praktijk.

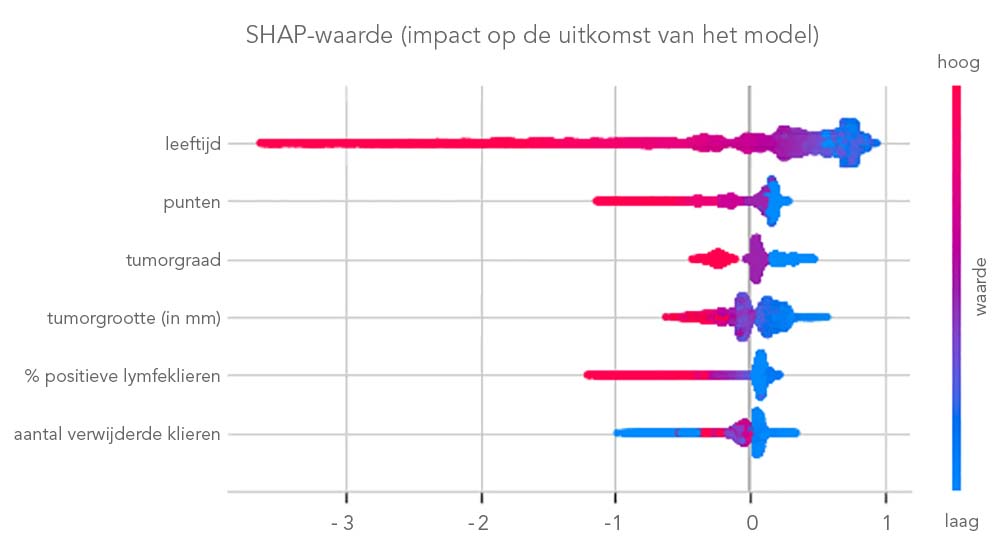

In een publicatie in Studies in Health Technology and Informatics presenteren Tom Jansen et al. een computergestuurd model voor de prognose van de algehele 10-jaarsoverleving van patiënten met borstkanker met behulp van data uit de Nederlandse Kankerregistratie (NKR). Vervolgens gebruikten zij het LIME-model (Local Interpretable Model-Agnostic Explanations) en het SHAP-model (SHapley Additive exPlanations) om de voorspellingen van het computergestuurd model te interpreteren.

Resultaten

De uitkomst van de analyses was dat het LIME- en SHAP-model over het geheel genomen de neiging hebben een consistente verklaring te geven voor de bijdrage van verschillende factoren. In 95% van de gevallen was er een overeenkomst tussen beide modellen. In een aantal gevallen gaf het LIME-model inconsistente en tegengestelde verklaringen voor individuele voorspellingen. Desalniettemin kan het bereik van deze factoren bij onjuiste weging ook interessant zijn, aangezien specifieke factoren kunnen helpen bij het identificeren van omslagpunten ten gunste of ten nadele van de overleving c.q. overlijden.

Conclusie en aanbevelingen

Tom Jansen en collega’s concluderen dat methodieken als LIME en SHAP zijn de eerste stap om complexe modellen beter te interpreteren en bieden inzicht in factoren die prognosemodellen zelf niet geven. Daarbij is het belangrijk om te realiseren dat perfecte verklaringen niet haalbaar zijn, omdat er geen gouden standaard bestaat waarmee deze verklaringen vergeleken kunnen worden. Dit betekent tegelijkertijd dat het evalueren van deze modellen een uitdaging is. Verklarende technieken kunnen de weg effenen voor een bredere acceptatie van computergestuurde leermodellen. De evaluatie en vertaling naar de klinische praktijk vergt aanvullend onderzoek.

- Tom Jansen, Gijs Geleijnse, Marissa Van Maaren, Mathijs P Hendriks, Annette Ten Teije, Arturo Moncada-Torres.Machine Learning Explainability in Breast Cancer Survival. Stud Health Technol Inform. 2020 Jun 16;

- Meer informatie over deze publicatie is verkrijgbaar via bibliotheek@iknl.nl